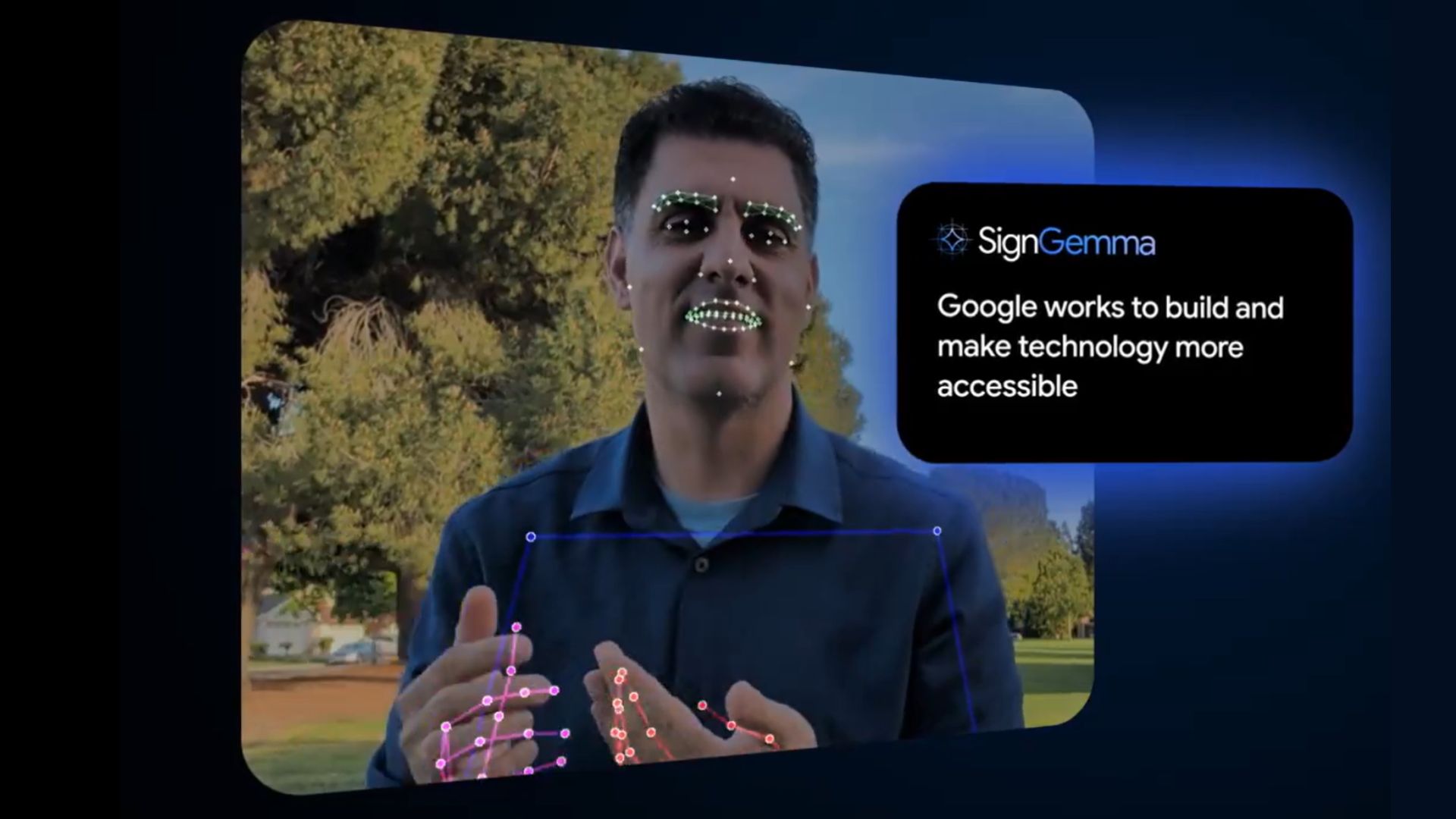

Las lenguas de señas son sistemas lingüísticos completos, visuales y espacio–temporales. Integrarlas en flujos digitales exige algo más que “ver” manos: requiere entender movimiento, contexto y gramática. Google DeepMind presentó SignGemma, un modelo derivado de la familia Gemma diseñado para traducir señas a texto (y voz) casi en tiempo real y, lo más relevante para las empresas, hacerlo potencialmente on‑device, sin depender de la nube para cada frame. En este artículo analizamos qué es SignGemma, por qué importa, cómo podría estar construido y qué implicaciones tiene para proyectos corporativos como los que desarrollamos en Raona.

Dónde encaja SignGemma en el ecosistema Gemma

Gemma es la línea de modelos abiertos de Google (Gemma 1/2/3, PaLI‑Gemma, CodeGemma, MedGemma, ShieldGemma…). La documentación oficial aún no incorpora SignGemma en sus tablas, lo que indica que estamos delante de un lanzamiento en fases: anuncio público, feedback de la comunidad y liberación posterior de pesos y guías.

SignGemma se posiciona como un special‑purpose model: aprovecha la base lingüística de Gemma para el lado textual, pero añade un frente de visión y secuencias temporales específico de señas. En otras palabras, hereda capacidades de razonamiento y generación de lenguaje del tronco Gemma y las combina con un encoder audiovisual entrenado para comprender articulaciones de manos, expresiones faciales y desplazamientos corporales.

Anatomía probable de SignGemma (advertencia: lectura técnica)

Aunque Google aún no ha publicado el paper, podemos inferir su arquitectura combinando prácticas del estado del arte y pistas del anuncio:

- Captura y normalización del movimiento: el vídeo entrante se trocea en ventanas de tiempo. Un módulo de estimación de pose (pose estimation) –similar a MediaPipe Hands/Face/Body o a arquitecturas tipo OpenPose/BlazePose– extrae puntos clave 2D/3D de manos, brazos, torso y rostro. Esto reduce el problema de “pixel soup” a secuencias estructuradas de “keypoints”.

- Encoder espaciotemporal: las secuencias de keypoints se alimentan a un transformador espaciotemporal o a un Graph Neural Network (GNN) que modela dependencias entre articulaciones y a lo largo del tiempo. Modelos recientes en sign language translation usan variantes de Spatio‑Temporal Graph Convolutional Networks (ST‑GCN) o Temporal Transformers con atención jerárquica.

- Representación lingüística intermedia (gloss o pseudo‑texto): muchas soluciones convierten primero señas a “glosses” (etiquetas léxicas simplificadas) y luego a texto continuo. Para evitar pérdida de información, es probable que SignGemma emplee una estrategia híbrida: CTC/Transducer para alinear frames con tokens y un decoder autoregresivo (Gemma) para la generación final.

- Decoder lingüístico Gemma: una variante ligera de Gemma actúa como generador de texto final. Aquí entra el fine‑tuning instruccional para producir salidas naturales, añadir puntuación, o incluso sintetizar voz mediante un TTS integrado.

- Inferencia en el dispositivo: para cumplir la promesa “on‑device”, el pipeline necesita cuantización (INT8/FP8), compilación con aceleradores móviles (NNAPI, Metal, GPU Adreno/ARM) y técnicas de streaming inference para emitir tokens mientras aún se recibe el gesto. Los módulos de visión probablemente operan a 20–30 FPS con latencias <100 ms por ventana.

Retos de datos: diversidad lingüística y ética

El mayor desafío no es únicamente técnico, sino lingüístico y social. Cada país (e incluso regiones) tiene su propia lengua de señas con gramáticas distintas. El entrenamiento requiere:

- Corpora de vídeo balanceados por dialecto, edad, iluminación, cámaras y estilos individuales de señar.

- Etiquetado experto: segmentar señas, asociarlas a glosses o frases y validar traducciones. Esto demanda comunidad sorda involucrada desde el diseño.

- Consideraciones de privacidad: grabar manos y rostros es un dato biométrico sensible. El procesamiento local ayuda, pero la gobernanza de datos sigue siendo crítica.

Métricas que realmente importan

En traducción de señas no basta con BLEU o sacarle WER al texto final. Proponemos un set mínimo de métricas cuando llegue el modelo:

- Sign Error Rate (SER) o precisión de reconocimiento de glosses si hay etapa intermedia.

- BLEU/BERTScore/COMET para la calidad de la traducción al lenguaje escrito.

- Latencia extremo a extremo (captura → texto/voz) y consumo energético en móvil.

- Robustez a oclusiones (una mano tapa a la otra) y variación de velocidad del signer.

¿Qué puede hacer una empresa hoy?

Mientras Google libera SignGemma, existen rutas viables:

- Implementar un prototipo con modelos abiertos como Phoenix‑2014T (alemán), CSL (chino) o ASLLVD (inglés) y un LLM de propósito general para post‑procesar. El objetivo es validar experiencia de usuario, canal de entrada (webcam, móvil, kiosco) y costes.

- Preparar datos internos: si tu organización ya trabaja con comunidades sordas, establece desde ahora protocolos de consentimiento, anotación y evaluación para cuando el modelo esté disponible.

- Diseñar la integración: ¿el output se enviará a un chatbot corporativo? ¿se convertirá en subtítulos en tiempo real para videollamadas internas? ¿se indexarán las consultas para analytics? Estos flujos definen requisitos de latencia, seguridad y cumplimiento.

Impacto para la accesibilidad corporativa

SignGemma puede transformar la accesibilidad de productos digitales: desde portales ciudadanos hasta apps bancarias. Al ejecutarse localmente, reduce barreras de conectividad y potencia la privacidad. Además, abre la puerta a experiencias bidireccionales: no solo que la persona sorda “hable” al sistema, sino que el sistema le responda en su misma lengua mediante avatar 3D o animación de señas.

Roadmap que debemos vigilar

- Publicación del paper/tech report con arquitectura y datasets.

- Lanzamiento de pesos y licencia (probablemente alineada con Gemma 2/3 Open).

- Release de SDK o ejemplos de referencia para Android/ChromeOS.

- Benchmarks independientes y comparativas con modelos académicos existentes.

- Extensión a más lenguas de señas y adaptación comunitaria.

Visión de Futuro

Estamos ante un punto de inflexión: los LLMs ya no solo leen y escriben, también “ven” y “escuchan” gestos. SignGemma encarna esa convergencia multimodal enfocada a la inclusión. En Raona seguiremos de cerca su evolución para ofrecer soluciones que no solo cumplan normativas de accesibilidad, sino que creen experiencias verdaderamente naturales para todas las personas. Si quieres explorar un piloto o preparar tu organización para esta ola, hablemos.

🔗¡Descárgate mi guía práctica para integrar la IA en tu empresa!

![Nuevas formas de trabajo en la era digital [2024]](https://raona.com/wp-content/uploads/2024/06/surface-HJgaV1qjHS0-unsplash-scaled-e1719411097367.jpg)