Base de conocimiento y modelo de lenguaje

Tanto los agentes personalizados creados con Copilot Studio como Microsoft 365 Copilot Chat se sustentan en la misma tecnología fundamental de IA. En el modo declarativo, los agentes de Copilot Studio aprovechan el mismo modelo de lenguaje de Azure OpenAI (por ejemplo GPT-4), la misma infraestructura de IA y el mismo orquestador central que Microsoft 365 Copilot . De hecho, Microsoft 365 Copilot (en sus aplicaciones de Word, Excel, Outlook, Teams, etc.) está respaldado por Azure OpenAI Service con LLMs privados (no la API pública de OpenAI) para garantizar seguridad y cumplimiento empresarial . Ambos, por tanto, comparten los mismos cimientos lingüísticos y las mismas protecciones de datos empresariales (Enterprise Data Protection), lo que significa que en igualdad de condiciones utilizan modelos de calidad equivalente. Las diferencias en sus respuestas no provienen del modelo subyacente (que es común), sino de cómo cada plataforma estructura la petición, busca información de contexto y presenta la respuesta.

Arquitectura y orquestación de consultas

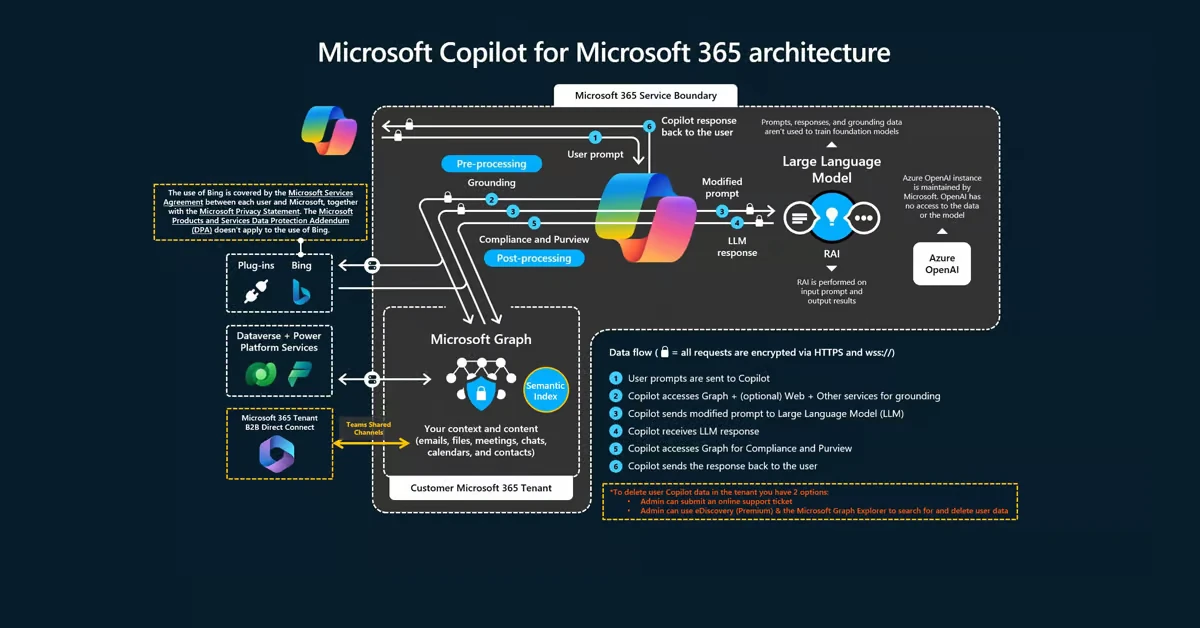

Microsoft 365 Copilot (Chat) es un servicio completamente integrado en el entorno M365. Su arquitectura incluye un Copilot service orquestador que intermedia entre el usuario, el modelo de lenguaje y las fuentes de datos de la organización . Cuando el usuario hace una pregunta o petición, Copilot consulta Microsoft Graph (que representa los datos del usuario y de la empresa: documentos de OneDrive/SharePoint, correos de Exchange, reuniones de Teams, chats, etc.) para “grounding” o contextualización: es decir, busca en los datos corporativos relevantes para la consulta. Para ello emplea un índice semántico avanzado denominado Semantic Index for Copilot, que mapea el contenido de la organización (archivos, conversaciones, elementos de CRM, etc.) en vectores semánticos para mejorar la relevancia de las búsquedas . Este índice semántico permite recuperar información por significado y contexto, no solo por palabras clave, lo que aumenta la calidad de las respuestas ancladas en datos empresariales. Además, Copilot Chat puede incorporar otras herramientas integradas (“plugins” internos): por ejemplo, realizar búsquedas web en tiempo real (“web grounding”) si la pregunta lo requiere, o invocar acciones a través de Microsoft Graph (como enviar un email, programar una reunión, editar un documento de Word, etc.) cuando el usuario lo solicita. Todo este flujo es manejado por la capa de orquestación de Copilot, que decide qué datos o herramientas necesita el LLM para responder y construye el mensaje final al modelo .

Por su parte, un agente creado en Copilot Studio (en modalidad declarativa) también se compone de una capa de orquestación que coordina modelos, instrucciones, conocimientos y acciones . Copilot Studio en sí forma parte de la Power Platform (basado en la tecnología de Power Virtual Agents), lo que ofrece una experiencia de bajo código para diseñar chatbots avanzados. Sin embargo, al habilitar la “generative orchestration” (orquestación generativa), estos agentes utilizan igualmente un LLM para interpretar la intención del usuario y decidir dinámicamente cómo conseguir la respuesta. Esto significa que el agente puede autonomamente elegir utilizar diferentes “herramientas” o recursos: puede invocar fuentes de conocimiento (p. ej., buscar en bases documentales conectadas), ejecutar acciones (APIs, flujos de Power Automate) o incluso delegar sub-tareas a otros agentes o topics predefinidos. En Copilot Studio, el creador del agente define qué capas y conectores están disponibles (por ejemplo, conectar a ciertos sitios de SharePoint, a una base de datos Dataverse, a un sistema CRM vía API, etc.), y el orquestador (si es generativo) decidirá en cada pregunta qué combinaciones usar para cumplir la petición del usuario. Importante: si el agente de Copilot Studio se configura como agente declarativo, entonces utiliza el mismo orquestador de Copilot de M365 en el backend. En cambio, Copilot Studio también permite crear agentes de “motor personalizado” (custom engine), donde la organización aporta su propio orquestador y modelo (por ejemplo, un LLM diferente o flujos más complejos). En ese caso sí habría divergencias mayores (pues la infraestructura ya no es la estándar de Copilot), pero aquí nos centraremos en los agentes declarativos, que son los más equivalentes al Copilot estándar.

Contexto y búsqueda de conocimiento (grounding)

Un factor clave que influye en la equivalencia o diferencia de respuestas es cómo cada sistema busca y proporciona el contexto documental al modelo de lenguaje. Microsoft 365 Copilot Chat trae incorporado por defecto el acceso a todos los datos de Microsoft 365 que el usuario puede ver, mapeados en el índice semántico de la empresa. Cada consulta del usuario activa una búsqueda en ese índice semántico a través de Microsoft Graph, obteniendo fragmentos relevantes de documentos, correos, chats, eventos, etc., que luego se pasan al LLM para generar una respuesta fundamentada . Por ejemplo, si un usuario pregunta “¿Cuáles son las políticas de vacaciones de la empresa?”, Copilot localizará automáticamente los documentos de recursos humanos pertinentes (en SharePoint, OneDrive, etc.) y sintetizará la respuesta apoyándose en ellos. Copilot Chat también admite que el usuario “comparta” un archivo específico en la conversación o lo suba directamente; en tal caso, el contenido completo de ese archivo se proporciona al modelo en contexto, permitiendo respuestas muy precisas basadas en ese documento . Además, con la característica de web grounding, Copilot Chat puede hacer búsquedas en Internet (vía Bing) cuando la pregunta es externa al conocimiento interno, y soporta cargas de archivos locales temporales (que no salen del perímetro de seguridad) .

En Copilot Studio, la búsqueda de conocimiento depende de cómo configuremos las fuentes de conocimiento del agente. El creador del agente puede vincular fuentes internas y externas específicas: por ejemplo, un sitio o biblioteca de SharePoint, ciertas carpetas de OneDrive, una base de Dataverse, conectores de Microsoft Graph (que indexan sistemas de terceros como Salesforce, ServiceNow, etc.), o incluso páginas web públicas definidas . En modo de orquestación generativa, el agente puede decidir buscar proactivamente en esas fuentes cuando la consulta lo requiera . Por defecto, al añadir una fuente SharePoint en Copilot Studio, la búsqueda se realiza mediante la API de búsqueda de Microsoft Graph tradicional: esto entrega generalmente los 3 resultados más relevantes por palabra clave coincidente, que luego son enviados al modelo para elaborar la respuesta . Este método básico puede ser menos preciso ya que es fundamentalmente una búsqueda lexical/keyword. No obstante, si la organización cuenta con licencias de M365 Copilot, Copilot Studio permite habilitar la opción de “Tenant Graph Grounding” o “Enhanced search results”, que integra el índice semántico en las búsquedas del agente . Con esta opción activada (lo cual requiere que el agente use autenticación de Entra ID y exista al menos un usuario con licencia Copilot en el tenant), las consultas del agente a SharePoint y a los conectores utilizan la misma búsqueda semántica avanzada que Copilot Chat, mejorando notablemente la relevancia de los fragmentos encontrados . De hecho, Microsoft indica que con Enhanced search activo, un agente puede indexar y buscar archivos de SharePoint de hasta 200 MB usando el índice semántico (por defecto está activado si hay licencia en el tenant) . En resumen, si el agente se configura con las mismas fuentes de datos y con la búsqueda semántica habilitada, debería recuperar información muy similar a la que recuperaría Copilot Chat para una pregunta equivalente.

Aun así, existen diferencias prácticas en la forma de aportar el contexto. Microsoft 365 Copilot, al estar integrado en las aplicaciones, puede tener acceso directo al contexto “inmediato” de trabajo del usuario. Por ejemplo, Copilot en Word “sabe” qué documento tienes abierto y puede usarlo directamente sin necesidad de buscarlo; Copilot en una reunión de Teams tiene acceso a la transcripción y asistentes de la reunión, etc. En cambio, un agente de Copilot Studio desplegado (por ejemplo en Teams como chatbot) no automáticamente conoce en qué documento o contexto está el usuario, a menos que el usuario mismo le provea esa información (por ejemplo, cargando un archivo al chat si es que el agente lo soporta, o indicándole algún ID). En general, un agente personalizado se basa en las búsquedas sobre sus fuentes configuradas y en la conversación previa, pero no está tan profundamente embebido en las aplicaciones de Office para capturar contexto automáticamente. Esto puede hacer que, en escenarios de productividad (ej. “ayúdame con este Excel que tengo abierto”), Copilot Chat ofrezca respuestas más ricas o acciones directas, mientras que el agente personalizado necesitaría que el usuario le facilite los datos (por ejemplo, copiando el contenido relevante o formulando la pregunta de forma descriptiva).

Acciones, plugins y flujos

Otra capa tecnológica a considerar es la capacidad de ejecutar acciones o usar herramientas adicionales en las respuestas. Microsoft 365 Copilot en su versión con licencia empresarial no solo responde con texto, sino que puede realizar tareas dentro de M365: por ejemplo, en Outlook puede enviar un correo que dictes, en Teams/Loop puede crear una página compartida (Copilot Pages), en Excel puede generar una fórmula o análisis de datos, etc. Estas funcionalidades realmente son posibles gracias a la integración de Copilot con las APIs de Microsoft Graph y comandos de las aplicaciones (a veces se les llama skills o plugins internos). El orquestador de Copilot decide invocar estas acciones cuando la petición lo demanda. Un ejemplo: “Copilot, programa una reunión con el equipo la semana próxima”. Copilot interpretará la intención y llamará a la API de Outlook Calendar para crear el evento, en lugar de solo describir cómo hacerlo. Todo esto forma parte de la arquitectura de Copilot Chat, presentando al usuario un resultado accionable (p. ej., “Reunión creada para el 10 de septiembre a las 10:00 AM con el equipo X”).

En Copilot Studio, lograr acciones similares requiere configuración explícita: el creador del agente puede definir “Custom actions” que vinculen el agente con APIs o flujos externos. Por ejemplo, se podría crear una acción para llamar a un servicio REST corporativo, o ejecutar un flujo de Power Automate, o actualizar un registro en una base de datos. Estas acciones se incorporan como herramientas disponibles y el agente (en orquestación generativa) puede decidir utilizarlas según la pregunta del usuario. Copilot Studio incluso soporta un estándar llamado Model Context Protocol (MCP) para conectarse fácilmente a servidores de conocimiento o APIs externas: al conectarse vía MCP, las acciones y datos de ese servidor se agregan automáticamente al agente. En esencia, esto permite expandir un agente con plugins personalizados más allá de lo que Copilot trae de fábrica. Ahora bien, si comparamos en igualdad de configuraciones (es decir, no añadimos acciones extra en el agente que Copilot Chat no tenga, ni viceversa), la capacidad de acciones “out-of-the-box” favorece a Copilot Chat dentro del ecosistema M365 (ya trae integraciones nativas con Outlook, Teams, etc.), mientras que un agente Studio tendría que replicarlas. Por ejemplo, un agente HR que construyamos podría no saber enviar un mail a un empleado a menos que le creemos esa acción, mientras que Copilot Chat sí puede componer un mail directamente en Outlook si se lo pedimos. Sin embargo, Copilot Studio ofrece libertad para integrar aplicaciones de terceros o procesos internos que el Copilot estándar no conocería. Esto significa que técnicamente la arquitectura de ambos soporta “plugins”, pero en Copilot Chat vienen predefinidos para Microsoft 365, y en Copilot Studio son configurables (y opcionalmente, compartibles a través de un catálogo de conectores). En cuanto a cómo afecta esto a las respuestas: si el usuario hace una pregunta puramente informativa, probablemente ambos agentes (uno estándar y otro personalizado) solo busquen información y respondan texto. Pero si la consulta implica una acción (“realiza X tarea”), Copilot Chat podría ejecutarla directamente si está dentro de su ámbito M365, mientras que el agente personalizado necesitará que esa acción esté implementada. En ausencia de una acción, el agente de Copilot Studio solo podría describir qué hacer en lugar de hacerlo efectivamente.

Experiencias reales: ¿respuestas equivalentes o diferentes?

En la práctica, un agente declarativo de Copilot Studio con la misma base documental, mismos permisos de usuario y misma configuración de modelo debería brindar respuestas muy similares a las de Microsoft 365 Copilot Chat, ya que ambos estarían usando GPT-4 con el mismo contenido de referencia. Microsoft enfatiza que los agentes declarativos heredan todo el cumplimiento de seguridad y uso del mismo motor de Copilot, de modo que no hay diferencias deliberadas en la “inteligencia” de las respuestas . En la práctica, sí se han observado divergencias en ciertos casos, normalmente atribuibles a cómo cada uno realiza el grounding o a detalles de implementación.

Un ejemplo concreto: un usuario creó un agente de RR.HH. en Copilot Studio conectado a documentos de políticas corporativas en SharePoint, y lo comparó con Copilot Chat respondiendo preguntas sobre esas mismas políticas. Descubrió que Copilot Chat respondía correctamente a preguntas sobre un documento extenso sin inconvenientes, mientras que el agente personalizado (Copilot Studio) a veces no encontraba la información o respondía de forma incompleta . Tuvieron que reorganizar el documento (por ejemplo, simplificando tablas complejas en listas de viñetas) para que el agente pudiera “leerlo” mejor y contestar, algo que con Copilot Chat no fue necesario. Al crear un agente declarativo “M365” (desde la propia interfaz de Copilot en Microsoft 365) y compararlo con el agente creado en Copilot Studio, “el agente basado en M365 fue significativamente mejor” en la tarea de preguntas y respuestas que su equivalente de Copilot Studio . La conclusión preliminar fue que parecen existir diferencias en la orquestación, indexación y estrategia de búsqueda entre ambos, dando una ventaja al agente de M365 Copilot en escenarios sencillos de Q&A corporativo . En otras palabras, aun teniendo la misma fuente documental, el agente de Copilot Studio inicialmente no estaba alcanzando el mismo nivel de comprensión/búsqueda que Copilot Chat.

¿Qué explica estas diferencias? Los análisis apuntan a que, sin ajustes, el agente personalizado estaba usando una búsqueda más básica (por keywords mediante Graph) y quizás no estaba capturando ciertos contenidos (por límites de tamaño o formatos como tablas) . Copilot Chat, por su lado, posiblemente obtenía mejor contexto gracias al índice semántico y a que el usuario podía haber “compartido” directamente el documento en el chat, permitiendo al LLM analizarlo globalmente. Al habilitar la opción de búsqueda semántica (tenant grounding) en el agente Studio, la diferencia debería reducirse, ya que entonces ambos usarían el mismo método de embedding para recuperar fragmentos relevantes. Por tanto podemos inferir que “usar solo SharePoint [en Copilot Studio] hará una búsqueda Graph clásica con resultados limitados – la calidad es bastante mala. Si tienes licencia M365 Copilot… activa el grounding con índice semántico para obtener mejores resultados”. Es decir, la configuración lo es todo: un agente Studio mal configurado puede dar respuestas inferiores, pero configurado de manera óptima puede igualar al Copilot Chat.

Otro aspecto observado es la interpretación de estructuras complejas en documentos. Un documento con tablas anidadas, celdas combinadas o formatos inusuales puede ser indexado de forma imperfecta por las herramientas de búsqueda. En la experiencia mencionada, Copilot Chat logró extraer la respuesta desde una tabla compleja, posiblemente porque el LLM pudo leer la tabla entera cuando el documento fue compartido en el chat. El agente personalizado, al depender de un índice fragmentado, no “veía” la tabla completa a menos que las consultas coincidieran exactamente con partes de ella, de ahí la necesidad de reestructurar la información. Esto indica que Copilot Chat podría tener mecanismos más robustos para entender documentos completos en ciertos casos (especialmente cuando el usuario explícitamente inserta el documento en la conversación), mientras que el agente declarativo depende de la estrategia de división y búsqueda de conocimiento configurada en Studio.

En cuanto al tono y formato de las respuestas, ambos agentes utilizan por defecto las capacidades conversacionales de GPT-4, pero pueden presentar ligeras variaciones debido a las instrucciones del sistema o prompt base. Microsoft 365 Copilot Chat tiene predefinido un comportamiento consistente con la guía de estilo de Microsoft: respuestas profesionales, concisas, que a menudo refieren la fuente (por ejemplo, “Según tus documentos de OneDrive, la política de vacaciones es…”). Copilot Studio permite personalizar instrucciones: un creador podría indicarle al agente que responda de forma más detallada, o que cite texto exacto, o que use cierto tono (“como un asesor amable”, etc.). Estas diferencias de configuración obviamente influirán en la salida. No obstante, si no se cambia nada, un agente declarativo nuevo también traer instrucciones genéricas para ser útil y cumplir principios de IA responsable similares a Copilot. En resumen, no hay un sesgo intencional que haga que Copilot Chat “sepa más” o “responda mejor” que un agente personalizado sobre la misma data; las divergencias provienen de detalles de implementación: qué encontró en la búsqueda, cuánta información se pasó al modelo, y qué directrices de formato tiene cada uno.

Diferencias técnicas internas y sus implicaciones

¿Existen rutas técnicas distintas detrás de cada solución? En buena medida, Microsoft ha diseñado Copilot Studio precisamente para aprovechar la infraestructura de Copilot ya existente, extendiéndola a casos personalizados. Los agentes declarativos de Studio “montan” sobre la capa de Copilot: usan el Copilot orchestrator en la nube de Microsoft 365, usan el mismo GPT-4, respetan los permisos de Graph, y cumplen las políticas de seguridad y IA responsable de la plataforma . Esto garantiza consistencia en fundamentos y seguridad. Sin embargo, alrededor de ese núcleo común, cada enfoque tiene distintas capas adicionales:

- Capas de datos y búsqueda: Microsoft 365 Copilot tiene por defecto todo el Graph y el índice semántico de la organización a su disposición, mientras que un agente Copilot Studio tiene un alcance delimitado por las fuentes añadidas (pueden ser amplias, pero no automáticamente “todo” a menos que así se configure con conectores enterprise) . Un agente puede, por ejemplo, ser limitado a buscar solo en una colección de manuales técnicos en SharePoint y en un par de sitios web públicos relevantes – ignorará el resto del Graph aunque el usuario tenga más contenido, a menos que se agregue. Esto acota el contexto, lo cual puede ser bueno (mantiene la respuesta enfocada al dominio deseado) pero también puede hacer que falte alguna información transversal que Copilot Chat sí encontraría en otra fuente general. Por tanto, la consistencia de las respuestas depende de haber incluido todas las fuentes necesarias en el agente; de lo contrario, podría responder “No tengo esa información” donde Copilot Chat sí la encontraría en otro repositorio disponible.

- Orquestación y lógica de negocio: Copilot Chat sigue una orquestación estándar optimizada para productividad personal y colaboración. Un agente personalizado puede incorporar lógica adicional. Por ejemplo, podemos hacer que antes de responder, el agente verifique vía API cierta información actualizada (un stock de inventario, o la cotización del día) y use eso en la respuesta. Esto crea una ruta técnica distinta (llamadas adicionales, procesamiento extra) que obviamente puede dar una respuesta más completa en cierto contexto que Copilot Chat no lograría por sí solo (puesto que Copilot Chat actualmente no sabe conectar a esas API específicas). Inversamente, Copilot Chat tiene lógica interna para determinadas peticiones (por ejemplo, la “recapitulación inteligente” de reuniones de Teams es una funcionalidad propia de Copilot Chat, con procesamiento de transcripciones, etiquetado de oradores, etc., que un agente básico de Studio no replicará a menos que se programe explícitamente). Así, cada uno tiene fortalezas: Copilot Chat es muy capaz en los escenarios integrados que Microsoft ha previsto (documentos Office, reuniones, email, análisis de datos en Excel, etc.), mientras que Copilot Studio permite orquestar escenarios personalizados o procesos multi-sistema. Esto influye en que las respuestas puedan divergir si la pregunta toca esas áreas. Por ejemplo, “¿Puedes preparar un resumen de la reunión de ayer con conclusiones y próximos pasos?”: Copilot Chat (con la licencia adecuada) accederá a la reunión de Teams de ayer, obtendrá la transcripción y generará la recapitulación con quién dijo qué, tareas identificadas, etc. Un agente genérico de Studio no tiene esa capacidad lista; probablemente diría que no tiene datos de reuniones, a menos que uno lo haya conectado a la API de Teams y entrenado en extraer ese tipo de información, lo cual sería un trabajo adicional. En preguntas más estándar (p. ej. “¿Cuál es la política de vacaciones?”), ambos buscarán en textos y deberían converger si tienen el mismo contenido.

- Limitaciones y metadatos: Según documentación, los agentes Studio tienen ciertos límites de configuración (número de fuentes, tamaño de archivos indexables, etc.). Por ejemplo, hasta 25 sitios de SharePoint por agente en modo generativo , cierto tamaño máximo por archivo (200 MB con índice semántico, 50 MB en algunos casos sin él, etc.) . Microsoft 365 Copilot, al ser un servicio global, puede indexar cientos de miles de documentos de todo el tenant (aunque seguramente también con límites altos) y utiliza ranking inteligente para encontrar lo más relevante . En la práctica esto significa que un agente muy acotado podría pasar por alto información porque quedó fuera de sus 25 sitios configurados, mientras Copilot Chat la hallaría en el sitio número 26. Por ello, para lograr consistencia, la selección de fuentes en Copilot Studio debe ser cuidadosa. Microsoft recomienda usar Copilot Studio para escenarios enfocados, no para indexar absolutamente todos los datos de la empresa (lo cual sería difícil de mantener y costoso) . Copilot Chat ya está pensado para ese panorama amplio de “todos tus documentos y correos”. Esta diferencia de alcance puede llevar a divergencia simplemente porque el agente no sabe algo que Copilot Chat sí, por diseño.

Resumiendo las implicaciones: si se configuran con la misma base de conocimiento y capacidades, Copilot Chat y un agente de Copilot Studio tenderán a dar respuestas coherentes entre sí, ya que ambos llamarían al mismo modelo con inputs equivalentes. Las diferencias técnicas – en modelo (ninguna, usan el mismo), en flujo (ambos hacen RAG: Retrieval-Augmented Generation), en arquitectura (comparten la nube de Azure AI/Graph) – son mínimas en ese caso. No obstante, en escenarios reales, pequeñas divergencias en la configuración y orquestación pueden llevar a respuestas distintas. Copilot Chat aprovecha al máximo la infraestructura M365 preconfigurada, mientras que Copilot Studio requiere que el creador configure explícitamente todo el entorno del agente. Esto ofrece más control (por ejemplo, para forzar que solo use ciertas fuentes, o para añadir pasos lógicos), a costa de que si no se igualan todos los parámetros, puede percibirse una brecha de calidad o consistencia.

Conclusión

¿Equivalencia o diferencia en las respuestas? Si un agente de Copilot Studio y Microsoft 365 Copilot Chat operan sobre el mismo conjunto de datos, con los mismos permisos de usuario, y con las opciones de orquestación equivalentes, en general deberían producir respuestas muy similares, dado que comparten el cerebro (LLM) y las “lecturas” (datos) . Microsoft diseñó los agentes declarativos para extender a Copilot, no para tener un comportamiento divergente: de hecho, se habla de que los agentes “trabajan junto a o en nombre de” usuarios integrándose en Copilot . La consistencia por tanto fue un objetivo de diseño, garantizando las mismas garantías de seguridad, privacidad y calidad de modelo en ambos entornos. No hay evidencia de que Microsoft use modelos de lenguaje diferentes o inferiores para los agentes personalizados – ambos usan “los últimos LLM de Azure AI” con protección de datos de grado empresarial .

Dicho lo anterior, en la práctica pueden surgir diferencias notables si las rutas técnicas no se alinean exactamente. Microsoft 365 Copilot Chat puede aprovechar automáticamente el índice semántico y contexto amplio, mientras que un agente Studio mal configurado podría estar haciendo búsquedas más simples (p. ej. solo keywords) o limitadas, entregando así respuestas incompletas . También la experiencia de usuario influye: Copilot Chat tiene una interfaz unificada donde el usuario puede, por ejemplo, soltar un archivo en la ventana de chat para que Copilot lo use, o consultar datos de varias aplicaciones sin cambiar de contexto; un agente personalizado podría requerir pasos adicionales o no soportar ciertas entradas, afectando la interacción y posiblemente el resultado.

En términos de flujo de inferencia, ambos agentes siguen el patrón prompt -> grounding -> respuesta con LLM. La diferencia es quién y cómo compone ese prompt final. En Copilot Chat, el prompt del modelo es construido por el servicio de Copilot incorporando las instrucciones base de Microsoft, la pregunta del usuario y los datos encontrados en Graph (y quizá alguna herramienta/acción elegida). En Copilot Studio, el prompt es construido por la lógica del agente: en orquestación generativa, el agente forma un prompt que incluye las descripciones de herramientas/conocimientos relevantes, los resultados de búsqueda de sus fuentes y la pregunta del usuario . Si ambos incluyen la misma información textual de apoyo, el modelo GPT producirá esencialmente la misma respuesta (puede variar en redacción, ya que es estocástico, pero cubrirá los mismos puntos). Cualquier discrepancia significativa suele deberse a que no incluían exactamente los mismos datos de apoyo.

Finalmente, cabe destacar que Microsoft está evolucionando rápidamente estas plataformas. Con cada actualización, la paridad entre Copilot Chat y los agentes podría mejorar. Por ejemplo, Microsoft ha introducido mejoras como MCP (para integrar fácilmente datos externos en agentes) y seguirá optimizando el índice semántico y la búsqueda. Es posible que con el tiempo un agente creado vía Copilot Studio tenga acceso más transparente al mismo índice global sin complicaciones, o que M365 Copilot permita seleccionar agentes especializados bajo el capó para ciertas consultas. De hecho, desde 2025, Copilot Chat incluye la capacidad de “descubrir y usar agentes” creados por la organización . Esto significa que un usuario final podría, dentro de Copilot Chat, invocar a un agente específico (por ejemplo “Agente de Finanzas”) que tiene un conocimiento o permisos particulares, todo desde la misma interfaz. En ese sentido, las fronteras entre “el Copilot general” y “los agentes de Copilot Studio” se difuminan: trabajan en conjunto más que en competencia. Si esos agentes están correctamente implementados, el usuario debiera notar una continuidad en la calidad de respuestas. En suma, no hay magia oculta que haga a Copilot Chat intrínsecamente más inteligente que un agente bien construido con las mismas bases – pero la carga de la prueba recae en la configuración del agente. Con las configuraciones adecuadas (mismas fuentes, búsqueda semántica activa, instrucciones similares), se puede lograr paridad en las respuestas . Con configuraciones divergentes, se manifestarán diferencias en alcance o detalle, como han señalado algunos análisis públicos . La clave está en entender las capas técnicas (Azure AI, índice semántico, conectores, grounding) y usarlas de forma consistente en ambos. De esa forma, las respuestas de ambos tipos de agentes podrán ser tan equivalentes como uno desee, o deliberadamente distintas si ese es el objetivo (por ejemplo, un agente con un rol/personalidad diferente).

Referencias: Los puntos anteriores se basan en la documentación oficial de Microsoft (incluyendo Microsoft Learn y blogs técnicos), en declaraciones de la propia Microsoft sobre Copilot, así como en análisis comparativos de nuestras propias pruebas en escenarios reales.